Einführung

Im Jahr 2018 habe ich mit den Alexa-Skill-Developer Tools von Amazon experimentiert. Ich erinnere mich noch genau daran, wie faszinierend es war, Erlebnisse zu entwickeln, die auf Sprachbefehle reagierten und kleine „On-Demand“-UI-Elemente auf Geräten wie dem Echo Show anzeigten. Es war ein Vorgeschmack darauf, wie Software aussehen könnte, wenn sie nicht mehr auf statische Menüs angewiesen ist, sondern auf menschliche Absichten reagiert.

Heute, einige Jahre später, ist diese Idee zu etwas deutlich Mächtigerem geworden. Das neue OpenAI Apps SDK öffnet die Tür zu einer neuen Generation von Mensch-Computer-Schnittstellen. Anstatt Nutzer durch feste Dashboards oder endlose Buttons zu zwingen, können wir jetzt Chat-ähnliche Erlebnisse schaffen, die genau dann die passende Oberfläche einblenden, wenn sie gebraucht wird - und wieder verschwinden, wenn nicht.

Diese Entwicklung verändert grundlegend, wie wir über Apps nachdenken. Mit dem OpenAI Apps SDK wird ChatGPT zu einer flexiblen Entwicklungsplattform, in der Sprache, Logik und Nutzererlebnis nahtlos zusammenfließen. Deine App kann Daten anzeigen, Fragen stellen oder Aufgaben direkt innerhalb eines Gesprächs ausführen - für ein flüssigeres, natürlicheres Nutzererlebnis.

In diesem Leitfaden zeige ich dir, wie du deine erste OpenAI-App mit dem Apps SDK baust - und warum dieser Moment die Art und Weise verändern könnte, wie Entwickler zukünftige digitale Erlebnisse gestalten.

Überblick über das OpenAI Apps SDK

OpenAI hat hier das Rad nicht neu erfunden. Die sogenannten Apps basieren auf dem weit verbreiteten Model Context Protocol (MCP). Durch die Erweiterung dieses Protokolls mit zusätzlichen Metadaten hat OpenAI eine Möglichkeit geschaffen, Interface-Intelligenz einzubringen. MCP bleibt der Kern, um Tools aufzurufen, Kontexte zu übergeben, Schemata zu validieren und Fehler zu handhaben. Das Apps SDK ergänzt diese Basis um UI-Metadaten, Definitionen und Hinweise, damit ChatGPT interaktive HTML-Elemente direkt im Gespräch rendern kann.

Bereits existierende MCP-Server können erweitert und somit in OpenAI-Apps verwandelt werden, indem sie die benötigten Metadaten zur Darstellungsebene hinzufügen. Dadurch kann ChatGPT UI-Komponenten intelligent abbilden und interaktiv rendern.

Die wichtigsten Bausteine sind:

- Der zentrale Server, der das MCP-Protokoll bereitstellt

- Tools, die die Fähigkeiten des MCP-Servers definieren und die Logik zur Verfügung stellen

- Resources, also „Pakete“, die UI-Komponenten beschreiben, die ChatGPT darstellen kann

- Widgets, die eigentlichen UI-Bausteine

Diese Elemente zusammen ermöglichen es, mit dem Apps SDK interaktive Erlebnisse zu entwickeln.

Entwicklerumgebung einrichten

Da das OpenAI Apps SDK auf dem etablierten MCP-Protokoll basiert, kannst du die vorhandenen Tools weiterverwenden. Du kannst entweder Python oder TypeScript/JavaScript verwenden - in diesem Beispiel nutzen wir TypeScript.

Stelle sicher, dass npm oder pnpm auf deinem Rechner installiert ist, und führe dann folgende Befehle aus:

mkdir my-openai-app

cd my-openai-app

pnpm init

pnpm add @modelcontextprotocol/sdk zod

pnpm add --save-dev typescript tsx @types/nodeWenn das erledigt ist, ist alles bereit zum Starten. Optional kannst du dein eigenes TypeScript-Setup in tsconfig.json konfigurieren. So sieht meine Konfiguration aus:

{

"compilerOptions": {

"target": "ES2022",

"module": "NodeNext",

"moduleResolution": "NodeNext",

"lib": ["ES2022"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true,

"resolveJsonModule": true,

"allowSyntheticDefaultImports": true,

"declaration": true,

"declarationMap": true,

"sourceMap": true

},

"include": ["src/**/*"],

"exclude": ["node_modules", "dist"]

}Deine erste OpenAI-App erstellen

Nun geht’s an die eigentliche Logik. Gemäß dem Model Context Protocol (MCP) benötigen wir einen Server mit einem /mcp-Endpoint. Dieser Server listet und stellt Tools bereit, die ChatGPT (oder ein anderer MCP-Client) verwenden kann. Um diesen Server zu bekommen benötigen wir folgende Teile:

Einen Server:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

const server = new Server(

{

name: "my-openai-app",

version: "0.1.0"

},{

capabilities: {

resources: {},

tools: {}

}

}

);Eine Liste von Tools:

const tools: Tool[] = [

{

name: "list_todos",

title: "List Todos",

description: "Gibt eine Liste von Todos mit einem interaktiven Dashboard zurück",

inputSchema: {

type: "object",

properties: {

priority: {

type: "string",

enum: ["high", "medium", "low", "all"],

description: "Nach Priorität filtern"

},

status: {

type: "string",

enum: ["pending", "in_progress", "completed", "all"],

description: "Nach Status filtern"

}

}

},

}

];Widgets & Ressourcen, die über _meta-Daten verbunden werden können:

const resources: Resource[] = [

{

uri: "ui://widget/todo-dashboard.html",

name: "Todo Dashboard Widget",

description: "Interaktives Todo-Dashboard",

mimeType: "text/html+skybridge",

_meta: widgetMeta

}

];

server.setRequestHandler(ListResourcesRequestSchema, async (_request: ListResourcesRequest) => ({

resources

}));

const widgetMeta = {

"openai/outputTemplate": "ui://widget/todo-dashboard.html",

"openai/toolInvocation/invoking": "Loading todo dashboard...",

"openai/toolInvocation/invoked": "Dashboard loaded",

"openai/widgetAccessible": true,

"openai/resultCanProduceWidget": true

}

const tools: Tool[] = [

{

name: "list_todos",

title: "List Todos",

description: "Returns a list of todos with an interactive visual dashboard",

inputSchema: {

type: "object",

properties: {

priority: {

type: "string",

enum: ["high", "medium", "low", "all"],

description: "Filter by todo priority"

},

status: {

type: "string",

enum: ["pending", "in_progress", "completed", "all"],

description: "Filter by todo status"

}

}

},

_meta: widgetMeta <--- füge diese Zeile hinzu

}

];Die UI-Elemente können auf viele Arten erstellt werden und müssen für die App selbst zugänglich gemacht werden.

Du kannst externe Ressourcen verwenden, die irgendwo gehostet sind, oder sie bei Bedarf direkt in deinem MCP-Server generieren/ Weitere Details findest du in den offiziellen Beispielen hier.

Die vollständige Anwendung aus diesem Tutorial findest du hier.

Testen und Debuggen deiner App

Sobald alles eingerichtet ist, kannst du deine Anwendung starten. Verwende dazu einfach pnpm dev, um sie lokal auszuführen.

Je nach verwendetem Port (in diesem Beispiel 8000) müssen wir unseren lokalen Server so freigeben, dass ChatGPT darauf zugreifen kann.

Dafür eignet sich ein Tool wie ngrok:

brew install ngrok

# registriere dich online, um deinen Authtoken zu erhalten

ngrok config add-authtoken <dein-auth-token>

ngrok http 8000

Damit erhältst du eine öffentlich zugängliche URL, die du in ChatGPT verwenden kannst, um deinen MCP-Server zu testen.

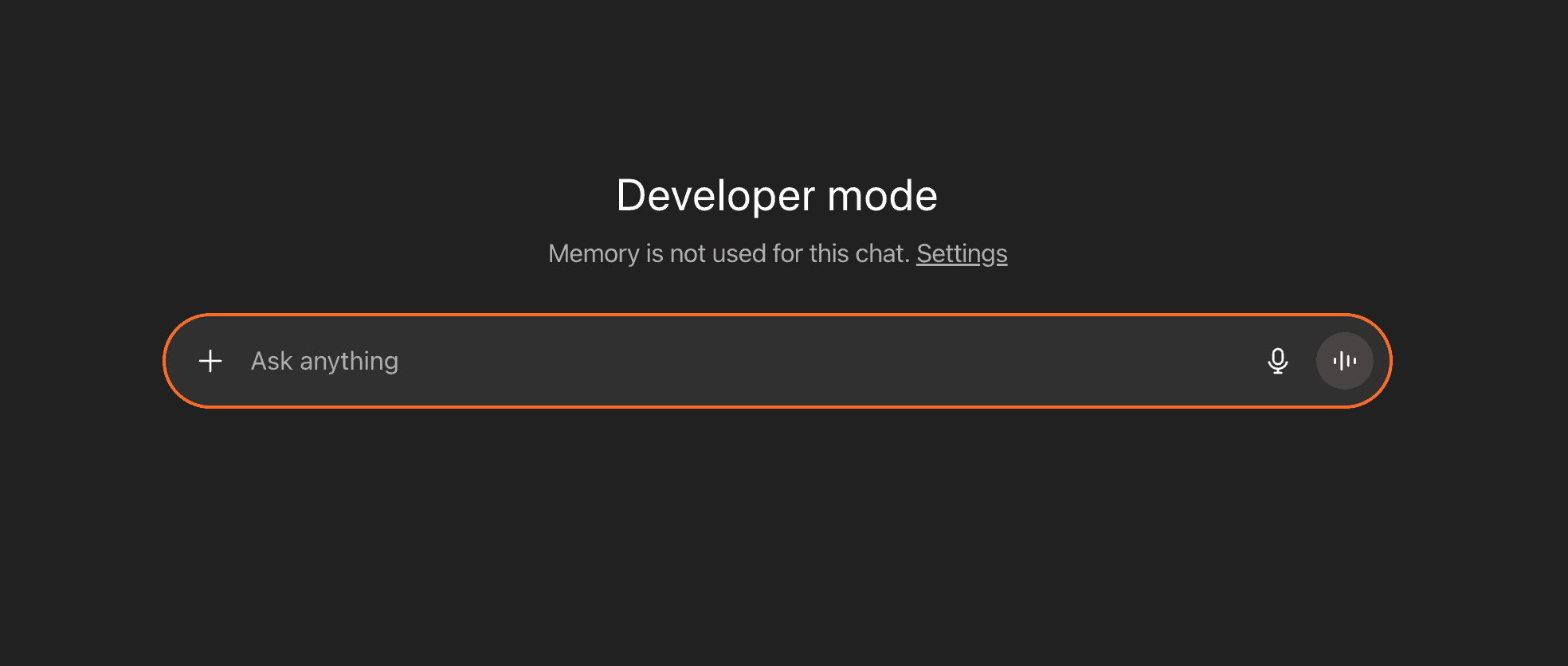

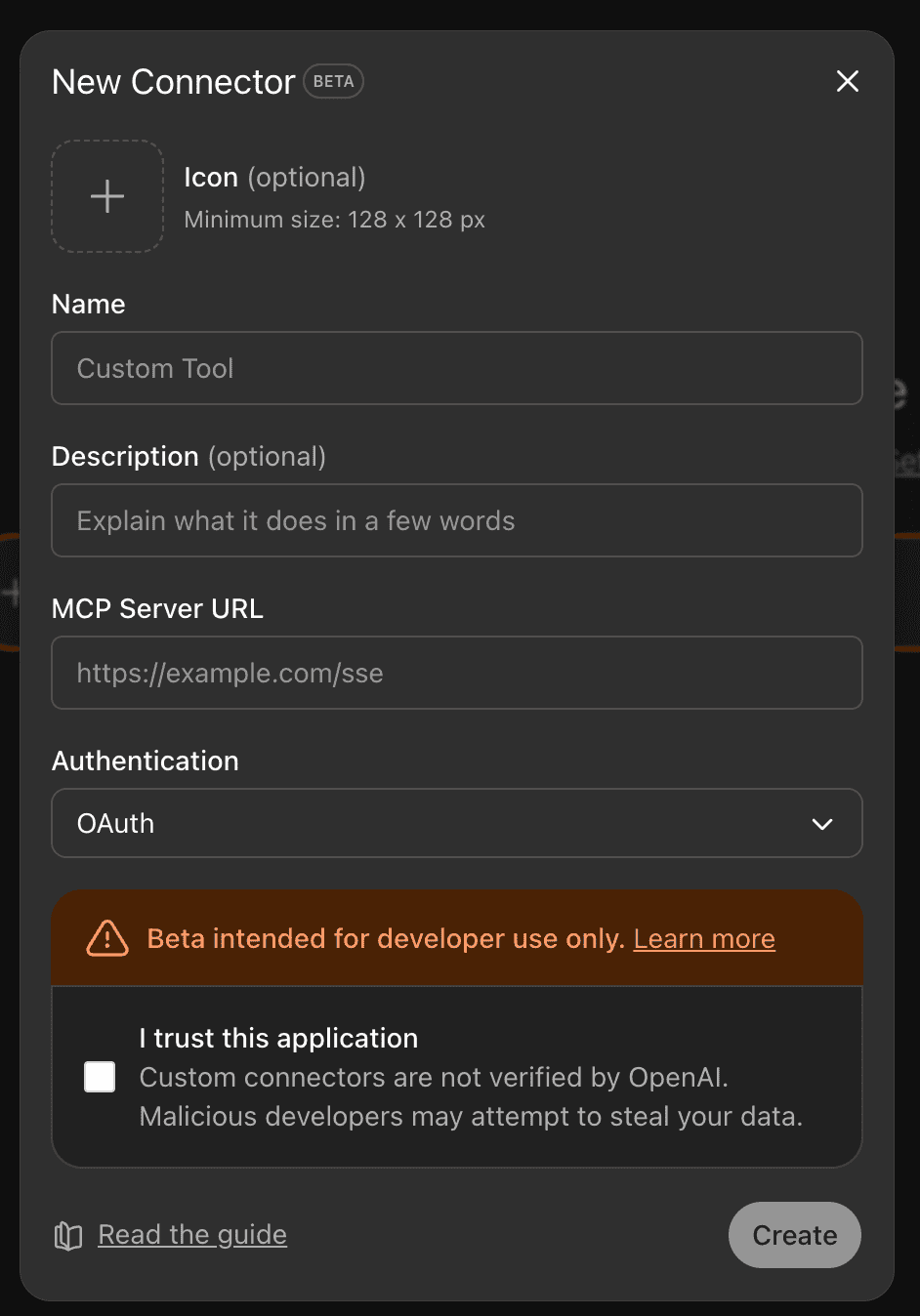

Öffne danach ChatGPT und gehe unten links in das Einstellungsmenü. Wähle dort Apps & Connector, dann Erweitert, und aktiviere den ntwicklermodus (Developer Mode). Sobald das aktiviert ist, sollte deine ChatGPT-Oberfläche wie auf dem folgenden Screenshot aussehen. Wechsle anschließend zurück zur Hauptansicht Apps & Connectors und erstelle eine neue App.

Trage die erforderlichen Informationen ein, füge deine öffentliche ngrok-URL + /mcp hinzu und wähle für dieses einfache Beispiel No Authentication aus. Für komplexere Szenarien ist OAuth erforderlich - weitere Informationen findest du hier.

Sobald alles geladen ist, solltest du die Tools in deiner Apps-Oberfläche sehen.

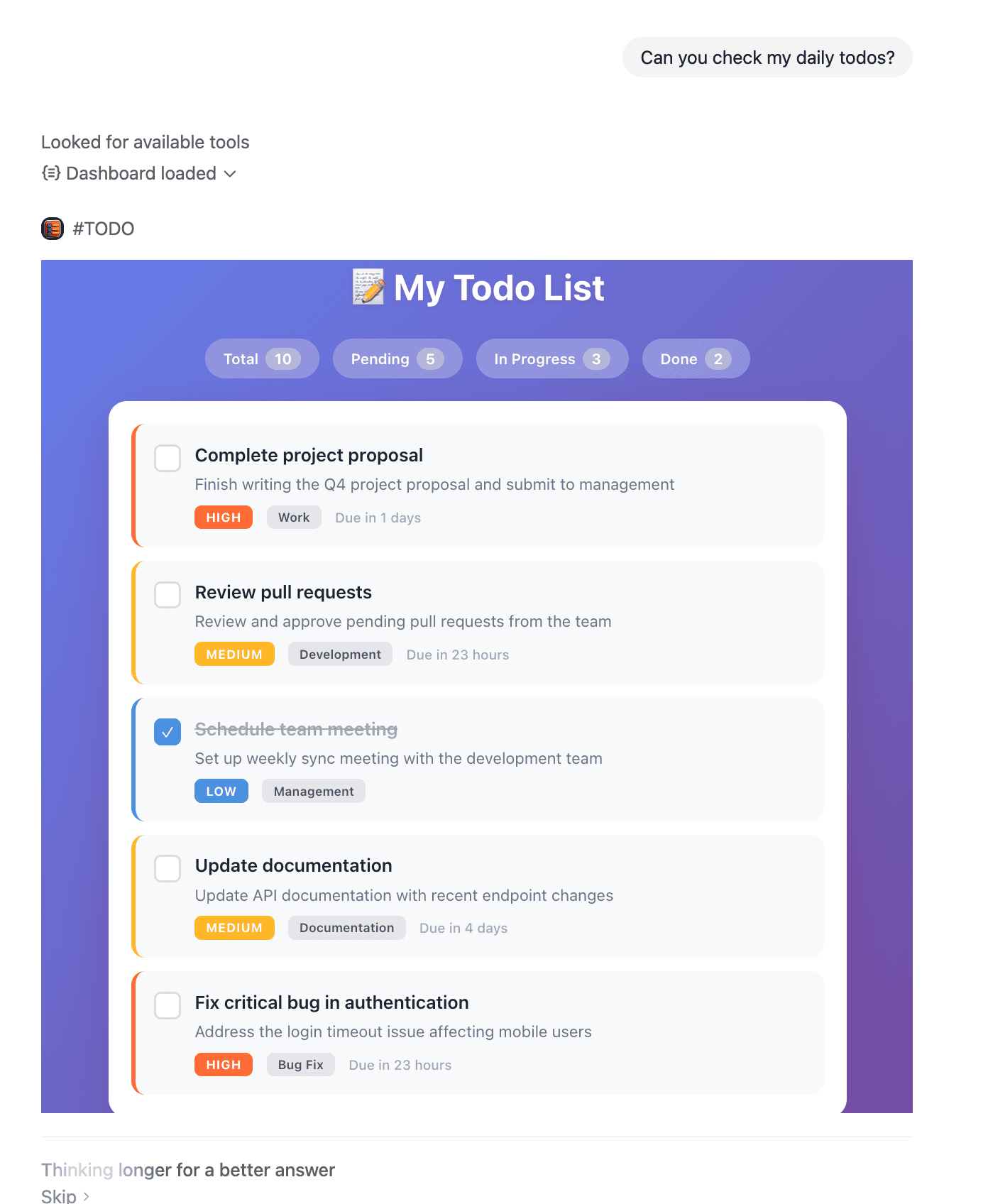

Probiere es gleich aus, indem du eine Eingabe wie diese machst:

„Hey ChatGPT, kannst du mir meine To-do-Liste zeigen?“

Und schon kannst du die Magie in Aktion sehen.

Veröffentlichen und Teilen deiner App

Aktuell befindet sich die OpenAI-Apps-Plattform noch in einer Early-Access-Phase, was bedeutet, dass eine öffentliche Veröffentlichung noch nicht für alle Entwickler verfügbar ist. OpenAI hat jedoch bereits angekündigt, einen offiziellen App Store zu starten, in dem Entwickler ihre Anwendungen für die breite ChatGPT-Nutzerschaft veröffentlichen können.

In der Zwischenzeit gibt es mehrere Möglichkeiten, wie du deine App teilen oder bereitstellen kannst:

1. Interne Bereitstellung für dein Team oder Unternehmen

Du kannst deinen MCP-Server in einer Produktionsumgebung (z. B. AWS, GCP oder Azure) deployen und mit OAuth-Authentifizierung absichern. So kann dein Team oder deine Kunden sicher über ihre ChatGPT-Oberfläche auf deine App zugreifen.

2. Entwickler-Tests und Feedback

Teile deine ngrok- oder Produktions-URL mit anderen Entwicklern, die den Entwicklermodus aktiviert haben. Das ist ideal, um frühzeitig Feedback zu erhalten und die Funktionalität sowie das UI deiner App zu verbessern.

3. Open-Source-Veröffentlichung

Überlege, deinen Quellcode auf GitHub zu veröffentlichen. Die Entwickler-Community arbeitet aktiv an OpenAI-Apps - wenn du dein Projekt open source stellst, können andere davon lernen und vielleicht sogar zu deinem Projekt beitragen.

4. Vorbereitung auf den App-Store-Start

Fange jetzt an zu bauen, damit du bereit bist, sobald der App Store online geht.

Achte dabei besonders auf:

- Eine saubere Benutzererfahrung und gutes Fehler-Handling

- Sichere Authentifizierung und Schutzmaßnahmen

- Umfassende Dokumentation

- Eine Sammlung von Apps, die verschiedene Anwendungsfälle zeigen

Behalte die offiziellen Ankündigungen von OpenAI und die Entwicklerdokumentation im Blick, um über Zeitpläne und Einreichungsrichtlinien für den App Store auf dem Laufenden zu bleiben.

Fazit

Das OpenAI Apps SDK markiert einen bedeutenden Wandel in der Art und Weise, wie wir Softwareoberflächen entwickeln. Durch die Kombination von natürlichem Sprachverständnis mit dynamischen, kontextabhängigen UI-Komponenten können wir Anwendungen schaffen, die sich weniger wie klassische Software und mehr wie intelligente Partner anfühlen.

Besonders spannend an diesem Moment ist, dass wir nicht einfach neue Funktionen entwickeln - wir gestalten das grundlegende Interaktionsmodell zwischen Mensch und Computer neu. Die konversationelle Oberfläche wird zur neuen Kommandozeile, und Widgets erscheinen genau dann, wenn sie gebraucht werden - so entstehen Erlebnisse, die sowohl mächtiger als auch intuitiver sind.

Für Entwickler ist das eine einmalige Gelegenheit, früh auf einer Plattform dabei zu sein, die das nächste Jahrzehnt der Softwareentwicklung prägen könnte. Die Fähigkeiten, die du jetzt aufbaust - Dialogflows entwerfen, adaptive Interfaces entwickeln und kontextgesteuerte UX denken - werden mit diesem Paradigma immer wichtiger. Egal, ob du interne Tools für dein Unternehmen baust, Produktivitäts-Apps für Endnutzer entwickelst oder mit völlig neuen Software-Kategorien experimentierst - das Apps SDK bietet dir das Fundament, um noch heute loszulegen.

Bereit, deine eigene OpenAI-App zu entwickeln?

Bei AVIMBU sind wir darauf spezialisiert, Unternehmen dabei zu unterstützen, KI-native Anwendungen zu entwerfen und umzusetzen. Wenn du deine App-Idee zum Leben erwecken oder Unterstützung beim Einstieg in diese neue Plattform suchst, helfen wir dir gern, die Zukunft der Mensch-Computer-Interaktion zu gestalten.

Jetzt ist der richtige Zeitpunkt, um zu experimentieren, zu lernen und dich an die Spitze dieser Veränderung zu setzen. Die konversationsbasierte Oberfläche ist nicht erst im Kommen - sie ist bereits da.

Referenzen

Hier sind einige interessante Quellen, auf denen dieser Blogbeitrag basiert:

- Introducing Apps in ChatGPT

- Model Context Protocol - Getting Started

- OpenAI Apps SDK - MCP Server Concepts

- OpenAI Apps SDK Dokumentation

Den Code zu diesem Tutorial findest du hier.